EM算法 |

您所在的位置:网站首页 › marcum q函数 › EM算法 |

EM算法

|

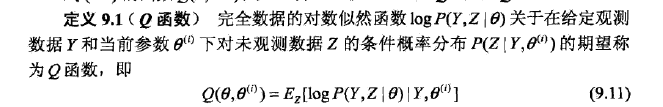

EM算法 原文链接:https://www.cnblogs.com/zdz8207/p/DeepLearning-em-gosimix.html 本文经过一定修改,个人认为原文中存在符号混用情况,对Q函数的角码使用不太清晰,容易晕 假设训练集 然而仅仅凭借似然函数,无法对参数进行求解。因为这里的随机变量 EM算法提供了一种巧妙的方式,可以通过逐步迭代逼近最大似然值。下面就来介绍下EM算法: 假设对于所有j, 其中第(2)步至第(3)步的推导就使用了Jensen不等式。其中:f(x)=log x, 这样,对于任意分布 由上式可得 上述等式最后一步使用了贝叶斯公示。最后一个公式 结论:得出了Q函数公式,在EM算法中可以直接使用,

EM算法有两个步骤: (1)通过设置初始化 (2)利用求出的 repeat until convergence{ (E-step) for each i, set (M-step) set

|

【本文地址】

今日新闻 |

推荐新闻 |